Python und AI – ein Traumpaar

Python und AI, Teil 1

Künstliche Intelligenz ist längst kein Zukunftsthema mehr – sie prägt bereits heute Softwareentwicklung, Automatisierung und digitale Produkte. Python spielt dabei eine Schlüsselrolle als universelle Sprache für Datenanalyse, Machine Learning und KI-Anwendungen. Dieser Artikel zeigt, warum gerade die Kombination aus AI und Python den Weg in die nächste Generation intelligenter Systeme ebnet.

Python hat sich in den letzten Jahrzehnten zur „Lingua franca“ („Verkehrssprache“) der Künstlichen Intelligenz (KI) entwickelt. Während frühe KI-Entwickler oft auf Sprachen wie Lisp oder später R und Matlab setzten, gewann Python ab den 2010er-Jahren rasant an Bedeutung. Gründe dafür sind die einfache Syntax, die große Standardbibliothek und vor allem die lebendige Community und das umfassende Ökosystem an KI-Bibliotheken. Unternehmen wie Google und Facebook investierten früh in Python-Tools für Machine Learning (ML) und Deep Learning, wodurch Python in Forschung und Industrie zum De-facto-Standard aufstieg.

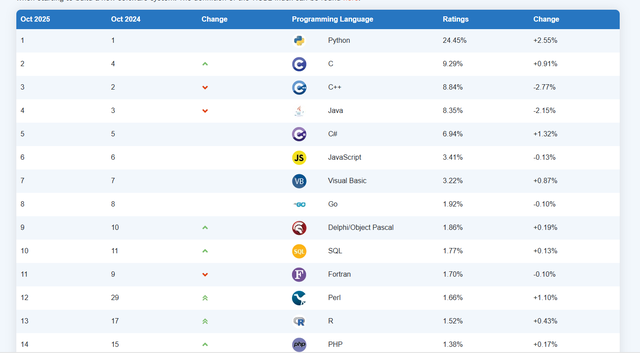

Heute ist Python im Machine-Learning- und Data-Science-Bereich allgegenwärtig. Umfragen belegen die Dominanz: Laut einer Kaggle-Studie nutzen über 80 Prozent der Data Scientists Python, während andere Sprachen weit abgeschlagen folgen (siehe auch Bild 1). Bereits zwischen 2016 und 2018 überholte Python die Statistik-Sprache R als meistgenutzte Sprache in der Datenanalyse. Inzwischen verwenden rund zwei Drittel aller Analytics-Fachleute Python als primäre Sprache. Diese Vorherrschaft spiegelt sich auch in Entwickler-Communities und Plattformen wider – auf Stack Overflow und GitHub rangiert Python regelmäßig an der Spitze der beliebtesten und meistgenutzten Sprachen.

Python als meistgenutzte Sprache im Tiobe-Index (Bild 1)

Tiobe-IndexEin wesentlicher Erfolgsfaktor ist Pythons niedrige Einstiegshürde bei gleichzeitig hoher Leistung und Flexibilität. Die Syntax ist leicht verständlich (oft wird gesagt, Python-Code lese sich „fast wie Englisch“), was sowohl Einsteigern als auch erfahrenen Entwicklern entgegenkommt. Zudem handelt es sich um eine interpretierte, plattformunabhängige Sprache – Python-Code läuft unter Linux, macOS und Windows ohne Anpassungen. Die Offenheit (Open Source) und die enorme Verbreitung führten zu einer Fülle von Online-Ressourcen, Tutorials und aktiven Foren. So ist über die Jahre eine Community von geschätzt mehr als 10 Millionen Entwicklern entstanden, die gemeinsam die Sprache weiterentwickeln und unterstützen. Nicht zuletzt verdankt Python seine KI-Dominanz dem breiten Ökosystem spezialisierter Bibliotheken und Tools, das früh entstand und ständig wächst. Von wissenschaftlichem Rechnen über Datenanalyse bis hin zu Deep Learning – für nahezu jeden Anwendungsfall gibt es ein Python-Paket. Dieser Reichtum an Libraries hat dazu geführt, dass Python für AI-Projekte oft als „One-Stop-Shop“ fungiert: Man findet alles Nötige in einer Sprache und kann unterschiedliche Schritte – Datenaufbereitung, Modelltraining, Visualisierung, Deployment – konsistent in Python umsetzen.

Im nächsten Abschnitt sehen wir uns einige dieser Kernbibliotheken des Python-Ökosystems genauer an, die Pythons Siegeszug in der KI maßgeblich mitbegründet haben.

Die Artikelserie „Python und AI“ beleuchtet praxisnah, wie Entwickler die Leistungsfähigkeit von Künstlicher Intelligenz mit der Flexibilität von Python verbinden können. Ziel ist es, den gesamten Entwicklungsprozess von der Idee bis zur produktiven Anwendung verständlich zu machen. Dabei werden theoretische Grundlagen, wichtige Frameworks und aktuelle Trends vorgestellt. Anhand konkreter Beispiele wird gezeigt, wie Machine Learning, Deep Learning und generative KI in Python umgesetzt werden. Jeder Teil der Serie vertieft ein zentrales Thema – von Datenverarbeitung über Modelltraining bis zur Integration in Anwendungen. So entsteht ein ganzheitlicher Leitfaden für den professionellen Einsatz von KI-Technologien mit Python.

Ökosystem – Bibliotheken

Ein entscheidender Vorteil Pythons ist das reichhaltige Ökosystem an Libraries, das für KI und wissenschaftliches Rechnen entwickelt wurde. Diese Bibliotheken machen Python zu einem leistungsstarken Werkzeugkasten, der die gesamte Pipeline von Daten bis Modell abdeckt. Im Folgenden geben wir ein Überblick über einige der wichtigsten Pakete und Frameworks:

- NumPy: Das Fundament für numerisches Rechnen in Python. NumPy stellt die ndarray-Datenstruktur (mehrdimensionale Arrays) bereit und bietet hochoptimierte Funktionen für mathematische Operationen, lineare Algebra und mehr. Viele andere Libraries bauen auf NumPy auf, da es schnelle Berechnungen auf C-Bibliotheken-Basis ermöglicht. Beispiel: Mit NumPy kann man Vektoren, Matrizen oder auch einfach große Zahlenarrays effizient verarbeiten.

- Pandas: Die Bibliothek für Datenanalyse und -manipulation. Pandas führt die Data-Frame-Struktur (bekannt aus R) in Python ein (DataFrame und Series) und erlaubt komfortables Laden, Filtern, Aggregieren und Transformieren von tabellarischen Daten. Für Datenvorverarbeitung in ML-Projekten ist Pandas oft das Werkzeug der Wahl, da es SQL-ähnliche Operationen auf In-Memory-Daten ermöglicht.

- Matplotlib: Das Urgestein der wissenschaftlichen Visualisierung. Mit Matplotlib können Entwickler hochflexibel 2D-Plots aller Art erstellen – von einfachen Linien- und Balkendiagrammen bis zu komplexen Wärme- oder 3D-Diagrammen. In Kombination mit Jupyter-Notebooks ist Matplotlib unverzichtbar für explorative Data Science: Modelle und Daten lassen sich visuell untersuchen, was das Verständnis und die Kommunikation von Ergebnissen erleichtert.

- Scikit-learn: Das Schweizer Taschenmesser für klassische Machine-Learning-Algorithmen. Scikit-learn bietet ein einheitliches API für Algorithmen in Bereichen Regression, Klassifikation, Clustering, Dimensionsreduktion, Feature-Engineering und Modellselektion. Mit wenigen Zeilen Code kann man Modelle trainieren, vorhersagen und evaluieren. Scikit-learn ist optimal für „klassisches“ ML (im Gegensatz zu Deep Learning) und wird wegen seiner Zuverlässigkeit und einfachen Handhabung sowohl in Lehre als auch Industrie geschätzt.

- TensorFlow: Googles Open-Source-Framework für Deep Learning. Seit seiner Veröffentlichung 2015 hat TensorFlow große Verbreitung gefunden, vor allem in Produktivsystemen. Es ermöglicht das Erstellen, Trainieren und Deployen neuronaler Netze auf verteilten Systemen. TensorFlow verwendet ein einfacheres High-Level-API (Keras) und unterstützt neben Python auch andere Sprachen für die Inferenz. Durch Erweiterungen wie TensorFlow Lite (für Mobile), TensorFlow Serving (für Deployment) und eine breite Tooling-Landschaft eignet es sich gut für den produktiven Einsatz skalierter KI-Systeme.

- PyTorch: Das Deep-Learning-Framework von Facebook (jetzt Meta AI), das besonders in der Forschung beliebt ist. PyTorch zeichnet sich durch eine „dynamische“ Berechnungsgrafik aus, das heißt, das Netzwerk kann während der Laufzeit modifiziert werden – was sehr intuitiv dem Python-Programmfluss folgt. Dies macht experimentelles Entwickeln von neuen Netzarchitekturen einfacher. In den letzten Jahren hat PyTorch TensorFlow auch in vielen Industrieanwendungen den Rang abgelaufen, da es durch seine Python-Nähe und klare Syntax bei Entwicklern punkten kann. Viele Standard-Modelle (zum Beispiel aus dem NLP-Bereich) werden zuerst in PyTorch veröffentlicht.

- Hugging Face: Ein relativ neues, aber revolutionierendes Ökosystem für vortrainierte Modelle und Transfer Learning. Hugging Face bietet die Transformers-Bibliothek mit Zugriff auf Tausende vortrainierte NLP-Modelle (von BERT bis GPT), eine Model-Hub-Plattform zum Austausch von Modellen sowie Tools für Datasets und Model Deployment. Man kann Hugging-Face-Modelle mit wenigen Zeilen Code laden und nutzen – was den Zugang zu modernen KI-Modellen enorm erleichtert. Inzwischen gibt es neben NLP auch Modelle für Vision, Audio und Multimodalität auf der Plattform. Hugging Face hat sich damit einen Ruf als „App Store für KI-Modelle“ erarbeitet.

Durch die Kombination dieser Bibliotheken lassen sich wissenschaftliche Berechnungen und Visualisierungen sehr einfach durchführen. Zusammenfassend bildet dieses Ökosystem das Rückgrat von Pythons Erfolg in der KI. Die Bibliotheken sind Open Source und frei verfügbar, werden ständig von der Community verbessert und oft von großen Tech-Firmen unterstützt. Dadurch bleibt das Ökosystem am Puls der Zeit: Neue Durchbrüche, beispielsweise ein neuartiger Algorithmus, werden meist umgehend in Python implementiert und der Allgemeinheit zugänglich gemacht.

Im nächsten Abschnitt wenden wir uns einigen klassischen ML-Methoden zu, die man – dank Libraries wie Scikit-learn – in Python besonders bequem einsetzen kann.

Klassische ML-Ansätze: Regression, Klassifikation, Clustering

Bevor Deep Learning allgegenwärtig wurde, dominierten im Machine Learning lange Zeit die klassischen ML-Algorithmen. Auch heute sind diese Methoden relevant – sei es wegen kleinerer Datensätze, besserer Interpretierbarkeit oder schlicht als Baseline. Python bietet mit Scikit-learn eine breite Palette solcher Algorithmen „out of the box“. Drei Grundaufgaben stehen im Zentrum:

- Regression: Dabei geht es um das Vorhersagen kontinuierlicher Werte. Ein einfaches Beispiel ist die lineare Regression, bei der eine Gerade (beziehungsweise Hyperfläche) so an Datenpunkte angepasst wird, dass die Abweichungen (Fehler) minimiert werden. Neben linearer und polynomialer Regression stellt Scikit-learn viele Varianten bereit, inklusive Metriken zur Bewertung (MSE, R²). Die Regression findet man zum Beispiel bei Prognosen von Preisen, Umsätzen oder Sensorwerten.

- Klassifikation: Hier sollen Datenpunkte in Kategorien (Klassen) eingeteilt werden. Ein Klassiker ist die binäre Klassifikation (zum Beispiel Spam versus Nicht-Spam in E-Mails). Algorithmen reichen von einfachen logistischen Regressionen über Support Vector Machines bis hin zu komplexeren Ensembles wie Random Forests oder Gradient Boosting. Mit Scikit-learn kann man zum Beispiel mit wenigen Zeilen einen Entscheidungsbaum trainieren oder einen Random Forest verwenden, um ein Klassifikationsproblem zu lösen. Die Bibliothek bietet viele Ansätze, das heißt, man ruft die Methode fit() auf und bekommt ein trainiertes Modell.

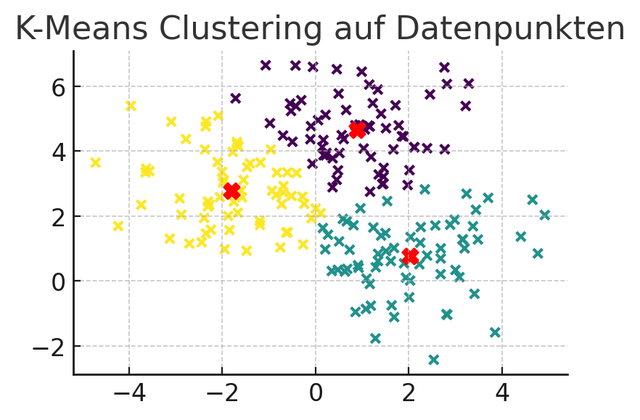

- Clustering: Dies ist ein Verfahren des unüberwachten Lernens, bei dem Datenpunkte anhand ihrer Ähnlichkeit in Gruppen (Cluster) eingeteilt werden, ohne dass es vorab bekannte Labels gibt. Ein populärer Algorithmus ist K-Means, der iterativ Cluster-Zentren bestimmt und Punkte zuordnet. Scikit-learn implementiert K-Means ebenso wie hierarchisches Clustering oder DBSCAN. Clustering wird genutzt, um in unstrukturierten Daten Strukturen zu finden – etwa Kundensegmente im Marketing oder Gruppen ähnlicher Artikel im E-Commerce (Bild 2).

Ergebnis einer Clusteranalyse (Bild 2)

AutorVisualisierungen helfen, das Ergebnis von Clustering zu verstehen – ein Vorteil von Python ist, dass man dank Libraries wie Matplotlib die Resultate sofort grafisch prüfen kann. Für Entwickler ist es beeindruckend, wie einfach sich diese klassischen ML-Methoden mit Python einsetzen lassen. Ein kurzer Code-Ausschnitt demonstriert dies für eine einfache Klassifikationsaufgabe mit dem Iris-Datensatz (siehe gleichnamigen Kasten).

Iris-Datensatz

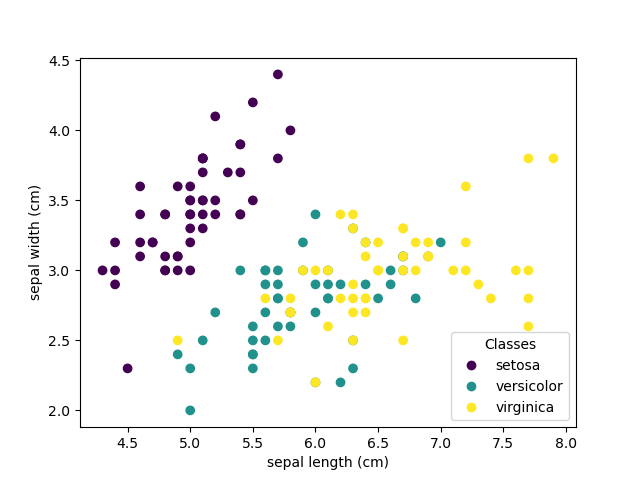

Der Iris-Datensatz ist ein Klassiker der Datenanalyse und des maschinellen Lernens. Er umfasst 150 Datensätze von Iris-Blüten, jeweils 50 pro Art: Iris setosa, Iris versicolor und Iris virginica. Für jede Blüte wurden vier Merkmale gemessen: Kelchblattlänge, Kelchblattbreite, Kronblattlänge und Kronblattbreite (in Zentimetern). Ziel ist es, anhand dieser Merkmale die jeweilige Iris-Art zu bestimmen (Bild 3).

Merkmalsverteilung im Iris-Datensatz (Bild 3)

AutorDieser Datensatz eignet sich hervorragend, um Klassifikationsverfahren, Visualisierungstechniken und Evaluierungsmethoden zu erlernen. Seine Einfachheit und klare Struktur machen ihn zum idealen Einstieg in die Welt der Datenwissenschaft und KI. Ein einfaches Beispiel lautet:

from sklearn.datasets import load_iris from sklearn.ensemble import RandomForestClassifier # Iris-Datensatz laden (Blütendaten von 3 Iris-Arten) X, y = load_iris(return_X_y=True) model = RandomForestClassifier() model.fit(X, y) # Training des Modells print(model.predict([[5.1, 3.5, 1.4, 0.2]])) # Ausgabe: array([0]) -> Vorhergesagte Klasse (Kodierung für Iris setosa)

In wenigen Zeilen werden hier Daten geladen, ein Modell initialisiert, trainiert (fit) und direkt für eine Prediction (Vorhersage) genutzt. Scikit-learn kümmert sich um Details wie das Splitten der Daten in Trainings-/Testmenge, Hyperparameter (sofern man keine spezifischen setzt) und bietet mit Methoden wie predict_proba auch gleich Wahrscheinlichkeiten für Vorhersagen an. Solche einheitlichen Schnittstellen über verschiedene Algorithmen hinweg machen den Experimentierprozess sehr effizient.

Kommen wir zurück zu unserer Ausgangsfrage: Warum klassische ML-Ansätze? Trotz des Hypes um Deep Learning gibt es viele Situationen, in denen ein einfaches Linear- oder Baummodell ausreicht und sogar Vorteile hat: Die Modelle sind oft schneller trainiert, benötigen weniger Daten und sind besser erklärbar. Außerdem lassen sich klassische Modelle leichter in Produktionsumgebungen integrieren, wenn zum Beispiel nur ein kleiner Microservice oder sogar ein Embedded Device die Inferenz durchführen soll. Python bietet hier also vom einfachen Prototyping bis zur Umsetzung ein rundes Paket.

Im nächsten Abschnitt wenden wir uns jedoch den neuronalen Netzen zu – dem Bereich, der in den letzten Jahren für die größten Durchbrüche in der KI gesorgt hat.

Deep Learning: Grundlagen neuronaler Netze

Deep Learning bezeichnet Methoden des maschinellen Lernens, die auf künstlichen neuronalen Netzen mit vielen Schichten (daher „tief“) basieren. Diese Netze sind vom Aufbau des menschlichen Gehirns inspiriert und haben in Bereichen wie Bilderkennung, Sprachverarbeitung und Spielen für revolutionäre Fortschritte gesorgt.

Ein künstliches neuronales Netz (Artificial Neural Network, ANN) besteht aus vielen einfachen Recheneinheiten (Neuronen), die in Schichten organisiert sind. Jede Verbindung zwischen Neuronen trägt ein Gewicht, und jedes Neuron berechnet eine Aktivierung (oft mittels einer nichtlinearen Aktivierungsfunktion) basierend auf den gewichteten Eingaben. Durch gestapelte Hidden Layers können Netze immer komplexere Merkmalsabbildungen lernen – dies nennt man auch hierarchisches Repräsentationslernen. Die erste Schicht lernt vielleicht einfache Kanten in einem Bild, die nächste Schicht daraus Formen, bis hin zu komplexen Objekten in höheren Schichten.

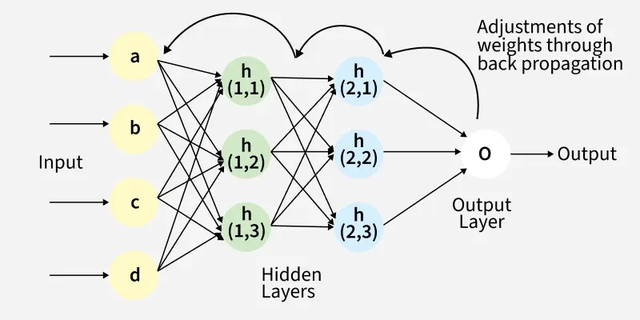

Der Lernprozess eines neuronalen Netzes läuft typischerweise über das überwachte Lernen mit dem Algorithmus der Backpropagation (Fehlerrückführung). Das Prinzip ist in Bild 4 dargestellt.

Backpropagation im Neural Network (Bild 4)

Geeksforgeeks.orgDabei wird zunächst eine Loss-Funktion definiert, die angibt, wie groß der Fehler zwischen Netzwerkausgabe und dem Sollwert ist. Backpropagation erlaubt es dann, diesen Fehler vom Output rückwärts durch das Netzwerk zu propagieren und auszurechnen, welcher Gewichtswert wie zum Gesamtfehler beiträgt. Mathematisch geschieht dies über die Ableitung (Gradient) der Loss-Funktion nach jedem Gewicht (Stichwort Gradient Descent). Auf diese Weise „lernen“ die Deep-Learning-Modelle, die die Grundlage der modernen KI bilden, selbstständig aus den Daten. Iterativ werden die Gewichte so angepasst, dass der Fehler auf den Trainingsdaten immer weiter sinkt – das Netz hat dann zum Beispiel gelernt, Bilder bestimmter Kategorien zu erkennen oder Sprache in Text umzuwandeln.

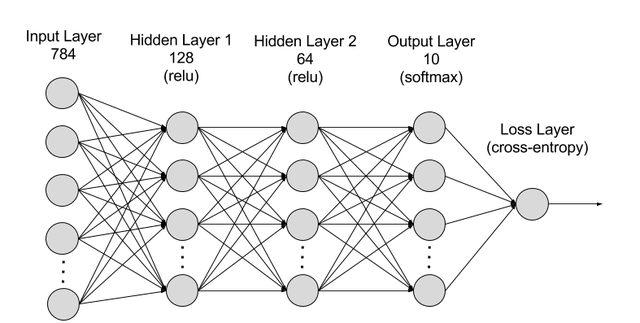

Ein einfaches Beispiel ist ein mehrschichtiges Perzeptron (MLP) zur Klassifikation: Eingabeneuronen nehmen Merkmale auf, es folgen eine oder mehrere verborgene Schichten, und eine Ausgabeschicht mit zum Beispiel Softmax-Aktivierung liefert Wahrscheinlichkeiten für Klassen. Trotz ihrer Einfachheit können solche Netze – ausreichend große Datenmengen und Rechenleistung vorausgesetzt – nahezu beliebige komplexe Zusammenhänge approximieren (Bild 5).

Neuronales Netzwerk (Bild 5)

Amazon AWSNatürlich gibt es diverse Spezialarchitekturen, zum Beispiel Convolutional Neural Networks (CNNs) für Bild- und Signalverarbeitung oder Sprache. Aktuell haben Transformer-Netzwerke viele vorherige Ansätze in NLP abgelöst. Doch allen gemeinsam ist das Grundprinzip: Gewichte werden via Daten und Gradientenabstieg optimiert.

TensorFlow versus PyTorch

Um Deep-Learning-Modelle zu implementieren und zu trainieren, greifen Entwickler heute fast ausschließlich zu speziellen Frameworks, die ihnen viel Boilerplate-Aufwand abnehmen und die Berechnungen auf GPUs optimieren. Die zwei dominierenden Frameworks in Python sind TensorFlow (Google) und PyTorch (Meta). Beide ermöglichen es, neuronale Netze zu definieren, effizient zu trainieren (auch auf verteilten Systemen) und in Produktion bereitzustellen. Dennoch gibt es wichtige Unterschiede in Philosophie und Handhabung:

- Berechnungsgrafik (Computation Graph): TensorFlow setzte ursprünglich auf einen statischen Graphen. Das heißt, man definiert zunächst das gesamte Netzwerk (eine Art Bauplan), bevor irgendwelche Daten fließen. Dieser Graph wird dann kompiliert und ausgeführt. Das erlaubt Optimierungen, erfordert aber manchmal umständlichere Debugging-Methoden. PyTorch hingegen nutzt von Anfang an einen dynamischen Graphen: Das Netzwerk verhält sich wie normaler Python-Code und kann in jeder Iteration verändert werden. Diese Dynamik fühlt sich für viele natürlicher an, da man zum Beispiel einfache if-Abfragen im Modell verwenden kann. Mittlerweile bietet TensorFlow im Eager Mode (und mit Keras) auch eine dynamischere Ausführung, aber PyTorch gilt als noch flexibler in diesem Punkt.

- Einsatzgebiet und Community: PyTorch wurde schnell zum Liebling der Forschungs-Community. Die Fehlersuche ist dank „Pythonic Style“ leicht, und man kann Modelle „on the fly“ ändern – ideal für Prototyping und Experimente. TensorFlow war lange Zeit im Produktiveinsatz verbreiteter, da es von Beginn an Tools für Deployment, Mobile (TensorFlow Lite) und Skalierung (verteiltes Training) im Blick hatte. Die statische Natur erlaubte Optimierungen, was bei sehr großen Modellen in Produktionsumgebungen vorteilhaft sein kann. Heute sind die Grenzen fließender – beide Frameworks werden aktiv weiterentwickelt und kommen in Forschung und Industrie zum Einsatz. TensorFlow hat durch Keras an Einsteigerfreundlichkeit gewonnen, PyTorch durch Projekte wie TorchServe oder ONNX an Production-Features.

TensorFlow und PyTorch sind sich aus Anwendersicht ähnlicher geworden. Beide bieten High-Level-APIs: In TensorFlow ist Keras das Standard-API, das heißt, dass Anweisungen wie model.fit() und so weiter die Handhabung vereinfachen. In PyTorch gibt es mit PyTorch Lightning oder fastai ebenfalls High-Level-Interfaces, die Boilerplate reduzieren. Dennoch gibt es Unterschiede: In PyTorch schreibt man standardmäßig den Trainingsloop von Hand, was maximale Kontrolle erlaubt, während man in TensorFlow/Keras oft innerhalb von model.fit() trainiert. Auch beim Debugging schwören viele auf PyTorch.

Es folgen zwei stark vereinfachte Code-Beispiele, die die unterschiedliche Herangehensweise illustrieren – einmal in PyTorch und daneben in TensorFlow (Keras):

# PyTorch: Einfaches neuronales Netz (Feedforward) manuell trainieren

import torch

import torch.nn as nn

# Netzwerk definieren (Eingang 10 -> Hidden 5 -> Ausgang 1)

model = nn.Sequential(

nn.Linear(10, 5),

nn.ReLU(),

nn.Linear(5, 1)

)

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

loss_fn = nn.MSELoss()

# Dummy-Daten (X: 100 Samples, 10 Features; y: Regressionsziel)

X = torch.randn(100, 10)

y = torch.randn(100, 1)

# Training-Schleife über 5 Epochen

for epoch in range(5):

optimizer.zero_grad() # Gradienten zurücksetzen

output = model(X) # Forward Pass

loss = loss_fn(output, y) # Loss berechnen

loss.backward() # Backpropagation

optimizer.step() # Gewichte aktualisieren

# TensorFlow/Keras: Ähnliches Netz definieren und trainieren

import tensorflow as tf

from tensorflow import keras

# Modell mit Keras-Sequential-API

model = keras.Sequential([

keras.layers.Dense(5, activation='relu', input_shape=(10,)),

keras.layers.Dense(1)

])

model.compile(optimizer='sgd', loss='mse')

# Dummy-Daten (zum Beispiel aus NumPy)

X = np.random.randn(100, 10).astype('float32')

y = np.random.randn(100, 1).astype('float32')

model.fit(X, y, epochs=5, batch_size=32) # Training via .fit()

Man sieht: In PyTorch erfolgt das Training eher manuell – ideal, um Einblick in jeden Schritt zu haben. In Keras übernimmt das Framework das Training (inklusive Batch-Verarbeitung) automatisch; man muss lediglich Daten und Epochenzahl angeben. Beide Ansätze haben Vor- und Nachteile: PyTorch gibt erfahrenen Entwicklern volle Kontrolle, Keras/TensorFlow nimmt einem Routinearbeit ab und bietet dafür viele eingebaute Features.

Leistungstechnisch sind beide Frameworks State of the Art. Bei Benchmarks hat TensorFlow bei sehr großen Modellen einen leichten Vorteil durch Graph-Optimierungen, während PyTorch durch dynamische Graphen minimalen Overhead haben kann. Diese Unterschiede sind in der Praxis aber selten entscheidend. Wichtiger ist, welches Framework im jeweiligen Team oder Ökosystem besser unterstützt wird. So hat TensorFlow zum Beispiel einen Vorteil, wenn man Googles TPU-Hardware nutzen will.

Zusammenfassend kann man sagen: PyTorch wird oft für Experimente und Forschung bevorzugt, TensorFlow für Produktion und Skalierung, auch wenn beide Bereiche sich überschneiden. Viele Unternehmen halten inzwischen beide Kompetenzen vor. Als Entwickler lohnt es sich, mit beiden zumindest grundlegend vertraut zu sein.

Im nächsten Abschnitt schauen wir uns den aktuellen Mega-Trend an, der eng mit Deep Learning verknüpft ist. Es geht um Generative AI und Large Language Models, die durch neue Architekturen (vor allem Transformer) ermöglicht wurden.

Generative AI und LLMs

Die jüngsten Durchbrüche im KI-Bereich sind eng mit Generative AI verbunden – Algorithmen also, die selbstständig Inhalte generieren können, seien es Texte, Bilder, Audio oder sogar Code. Insbesondere Large Language Models (LLMs) ab GPT-3, aber auch generative Bildmodelle wie Stable Diffusion haben ab 2023 enorme Aufmerksamkeit erlangt. Python spielt auch hier eine zentrale Rolle – sowohl bei der Forschung, das heißt, die meisten Papers veröffentlichen Python-Code zu neuen Modellen, als auch bei der Anwendung. Grundsätzlich sind viele generative Modelle über Python-Bibliotheken nutzbar.

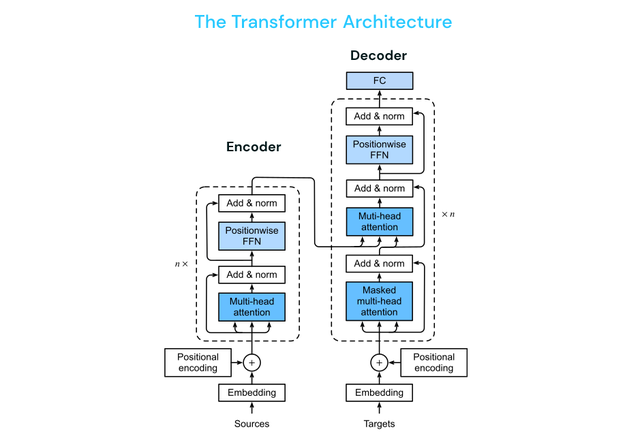

Den technischen Grundstein für die aktuelle LLM-Welle legte die Einführung der Transformer-Architektur (Bild 6). Transformer-Netzwerke haben klassische rekurrente Netze weitgehend abgelöst, da sie effizienter parallelisierbar sind und besser mit langen Abhängigkeiten umgehen können. Das Schlüsselkonzept ist die Self-Attention: Anstatt Tokens (zum Beispiel Wörter) sequenziell zu verarbeiten, betrachtet ein Transformer-Encoder alle Eingabetokens gleichzeitig und berechnet Gewichtungen dafür, wie stark jedes Token auf jedes andere „achten“ soll (attend). So kann das Modell kontextuell wichtige Informationen aus der gesamten Sequenz ziehen – etwa die Auflösung von Pronomen („er“, „sie“) über mehrere Sätze hinweg, was herkömmlichen RNNs schwerfiel. Die Self-Attention wirkt dabei wie ein Orchesterdirigent, der alle Instrumente gleichzeitig im Blick hat und abstimmt. Dadurch erfassen Transformer den Gesamtzusammenhang eines Satzes oder Dokuments wesentlich besser.

Transformer-Architektur (Bild 6)

BavestDiese Architektur bildet das Fundament der meisten heutigen LLMs. Typischerweise nutzt man einen sogenannten Decoder-Transformer. Modelle wie GPT sind große Transformer-Decoder, die darauf trainiert wurden, den nächsten Texttoken vorherzusagen (Language Modeling). Dabei kommen gigantische Trainingsdaten zum Einsatz.

Die GPT-Reihe (Generative Pre-trained Transformer) von OpenAI steht prototypisch für die Fähigkeiten moderner LLMs. GPT-3 (2020) beeindruckte mit flüssigen Texten, GPT-3.5 und dann GPT-4 (2023) legten nochmals deutlich zu – Letzteres kann nicht nur komplexe Anfragen in Textform beantworten, sondern ist auch multimodal (versteht Bilder) und zeigt Ansätze von logischem Schließen. Diese Modelle können Programmcode schreiben, Übersetzungen anfertigen, Inhalte zusammenfassen und sogar kreativ texten – was vielfältige Einsatzfelder eröffnet, von Chatbots über Assistenten bis zur automatisierten Berichterstellung. Mit GPT-5 (2025) erreicht die Modellreihe eine neue Stufe der Leistungsfähigkeit. Es kombiniert verbesserte kontextuelle Konsistenz mit einer feineren semantischen Präzision und kann über längere Dialoge hinweg kohärente, situationsangepasste Antworten liefern. Zudem wurde die multimodale Verarbeitung deutlich erweitert: GPT-5 versteht nun nicht nur Text und Bilder, sondern kann auch mit strukturierten Daten, Diagrammen oder Code-Ausschnitten sinnvoll interagieren. Besonders in der Softwareentwicklung eröffnet das neue Modell spannende Möglichkeiten – etwa beim automatisierten Refactoring, bei der Generierung von Tests, bei Code-Reviews oder der Erklärung komplexer Frameworks. Ein weiterer Fortschritt liegt in der Tool-Integration: GPT-5 kann externe Systeme wie Datenbanken, IDEs oder Web-APIs gezielt ansteuern, was den Übergang von der reinen Textverarbeitung hin zu aktiven KI-Assistenten markiert. Damit wächst der praktische Nutzen solcher Modelle enorm. Wichtig bleibt aber weiterhin: Auch GPT-5 basiert auf statistischer Mustererkennung – es simuliert Verständnis, anstatt tatsächlich zu „wissen“. Dennoch zeigen die Ergebnisse, wie weit die Entwicklung generativer KI in nur wenigen Jahren gekommen ist – und wie stark sie künftig die Arbeit von Entwickler:innen und Wissensarbeiter:innen verändern dürfte beziehungsweise bereits verändert hat.

Neben Text gibt es enorme Fortschritte bei generativen Bildmodellen. Hier haben sich seit 2021 sogenannte Diffusionsmodelle als neuer State of the Art etabliert. Diffusionsmodelle funktionieren nach einem zweistufigen Prinzip: Zuerst wird ein Trainingsbild schrittweise mit immer mehr Rauschen überlagert (bis es praktisch nur noch aus Zufallsrauschen besteht), anschließend lernt ein neuronales Netz, diesen Prozess umzukehren. Das Modell wird also darauf trainiert, aus purem Rauschen wieder ein sinnvolles Bild zu erzeugen, indem es Schritt für Schritt das Rauschen entfernt. Durch dieses Verfahren können Diffusionsmodelle hochqualitative, fotorealistische Bilder generieren – gesteuert durch sogenannte Prompts, das heißt Texteingaben, die beschreiben, was auf dem Bild zu sehen sein soll.

Stable Diffusion brachte 2022 den Durchbruch, da es als Open Source-Modell veröffentlicht wurde – seither existiert ein riesiges Ökosystem an Community-Modellen, Fine-Tunes (zum Beispiel für bestimmte Kunststile) und Tools, die auf Stable Diffusion aufbauen. Auch in anderen Bereichen zeigt sich das Prinzip der Diffusion vielversprechend, etwa für Audio-Generierung (zum Beispiel Geräuschesynthese) oder Moleküldesign in der Chemie/Pharma.

Als Entwickler kann man heute mit geringem Aufwand solche generativen Modelle nutzen. Beispielsweise lässt sich über die Bibliothek Hugging Face Diffusers ein Stable-Diffusion-Modell laden und mit wenigen Zeilen Code ein Bild zu einem gegebenen Prompt generieren. Wichtig zu beachten sind dabei jedoch die hohen Rechenanforderungen (vor allem eine potente GPU) und die potenziellen ethischen Herausforderungen. Trotzdem: Die Möglichkeit, per Python-Code Bilder zu malen oder Musik zu komponieren, war vor Kurzem noch Science-Fiction und demonstriert, wie weit das Feld der KI gekommen ist.

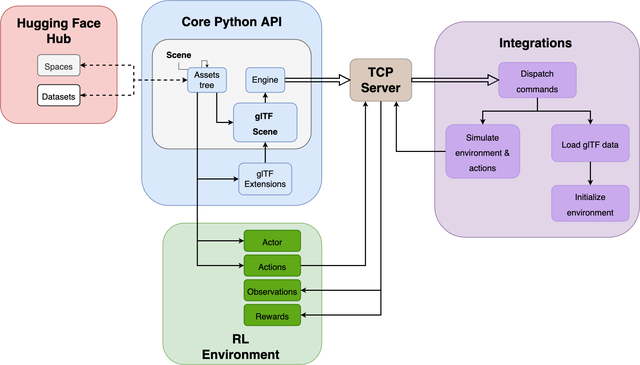

Im Zusammenhang mit generativer KI (und generell dem Einsatz vortrainierter Modelle) kommt man an Hugging Face kaum vorbei. Hugging Face bietet einen Modell-Hub mit über 500.000 Modellen – von kleinen BERT-Varianten bis zu großen LLMs wie Bloom oder LLaMA. Das Ziel von Hugging Face ist es, KI für alle zugänglich zu machen (Bild 7).

Hugging-Face-Hub mit Python-API (Bild 7)

Hugging FaceSo kann man etwa ein öffentlich verfügbares Modell für Sentiment-Analyse, Textgenerierung oder Bildbeschreibung mit dem Transformers-Package in Sekundenschnelle laden und direkt nutzen, ohne selbst ein komplexes Netz trainieren zu müssen. Ein einfaches Beispiel demonstriert dies:

from transformers import pipeline

# Pipeline für Sentiment-Analyse (Meinungsanalyse) laden

classifier = pipeline("sentiment-analysis")

result = classifier("I love using Python for AI projects!")

print(result)

# [{'label': 'POSITIVE', 'score': 0.9998}]

Hier wird ein vortrainiertes Modell aus dem Hugging-Face-Hub verwendet, um die Stimmung eines Beispieltextes zu analysieren – das Ergebnis ist POSITIVE mit hoher Wahrscheinlichkeit. Unter der Haube lädt pipeline() ein passendes Modell (standardmäßig ein DistilBERT-Modell feinjustiert auf Sentiment-Daten) herunter und führt die Inferenz durch. Ähnlich einfache Pipelines existieren für maschinelle Übersetzung, Named Entity Recognition (Eigennamenerkennung), Bildklassifikation und vieles mehr.

Hugging Face vereinfacht auch das Fine-Tuning eigener Modelle auf eigene Daten. Die Community teilt fleißig neue Modelle – Hugging Face ist damit zu einem Knotenpunkt der KI-Entwicklung geworden, ähnlich einem App-Store. Gewissermaßen kann „jeder“ mit nur wenigen Zeilen Python die besten KI-Modelle der Welt nutzen.

Natürlich sollte man auch die Risiken generativer Modelle nicht vergessen. Large Language Models können falsche oder halluzinierte Ausgaben produzieren, die für Laien überzeugend wirken. Generative Bildmodelle werfen Fragen zum Urheberrecht und Missbrauch (zum Beispiel Deepfakes) auf. Deshalb gewinnen die Themen Ethik und Verantwortung in der KI-Entwicklung an enormer Bedeutung. Darum geht es im nächsten Abschnitt.

Ethik und Verantwortung

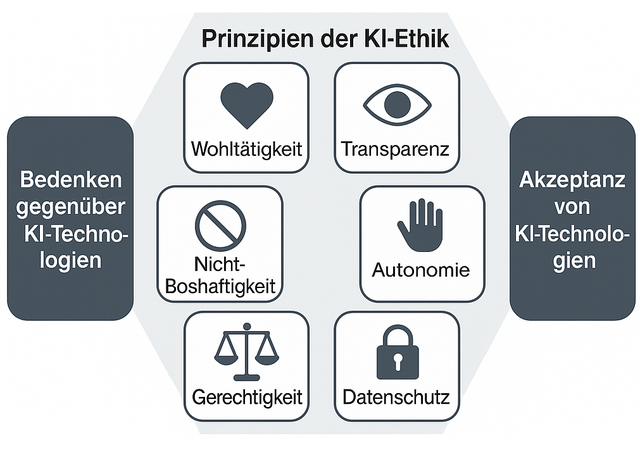

Mit der wachsenden Verbreitung von KI-Systemen tragen Entwickler eine große Verantwortung, diese Technologien ethisch und verantwortlich einzusetzen. Einige zentrale Aspekte dabei sind die Vermeidung von Bias (Voreingenommenheit) in Modellen, die Erklärbarkeit von KI-Entscheidungen sowie die Einhaltung rechtlicher Vorgaben wie dem europäischen AI Act (Bild 8).

Wichtige Prinzipien der KI-Ethik (Bild 8)

AutorBias bezeichnet systematische Verzerrungen oder Vorurteile in Daten und Modellen. Ein klassisches Beispiel ist ein Gesichtserkennungsmodell, das auf einem unausgewogenen Datensatz trainiert wurde und bei bestimmten Bevölkerungsgruppen deutlich schlechter funktioniert – etwa weil in den Trainingsdaten überwiegend Gesichter weißer Männer vorkamen. Solche Verzerrungen können zu diskriminierenden Outcomes führen (zum Beispiel Benachteiligung von Minderheiten bei Kreditwürdigkeitsprüfungen). Es ist daher essenziell, schon in der Datenvorbereitung auf Diversität und Repräsentativität zu achten und Modelle regelmäßig auf Bias zu prüfen. Der EU AI Act fordert für Hochrisiko-KI-Systeme explizit, dass hochwertige, vorurteilsfreie und repräsentative Trainingsdaten verwendet werden müssen. Entwickler sollten Techniken wie Bias-Metriken, Gegenmaßnahmen (Debiasing) und kontinuierliche Audits einsetzen, um verzerrte Ergebnisse zu erkennen und zu minimieren.

Viele leistungsstarke ML-Modelle, insbesondere Deep-Learning-Netze, agieren als Black Box. Sie liefern Vorhersagen, ohne dass ein Mensch direkt nachvollziehen kann, wie es dazu kam. In sicherheitskritischen Bereichen (Medizin, Justiz, autonome Fahrzeuge) ist jedoch Transparenz gefordert. Explainable AI (XAI) umfasst Methoden, um die Entscheidungen von KI-Systemen erklärbar zu machen. Dazu zählen zum Beispiel Feature-Importance-Techniken (Welche Eingabeattribute haben die Entscheidung am stärksten beeinflusst?) und Visualisierungen von Neuron-Aktivierungen in CNNs (zum Beispiel Heatmaps auf Bildern). Ziel ist es, das Modell für Menschen verständlicher zu machen. Dies stärkt das Vertrauen in KI-Systeme und ist in vielen Fällen mittlerweile sogar gesetzlich vorgeschrieben. In der EU verlangen Datenschutz-Grundverordnung (DSGVO) und der AI Act eine gewisse Erklärbarkeit beziehungsweise Begründbarkeit automatisierter Entscheidungen. So muss etwa einem Bewerber begründet werden können, warum ein algorithmisches System ihn abgelehnt hat. XAI ist somit ein Schlüsselelement von Responsible AI. Es fördert das Vertrauen der Anwender, ermöglicht die Nachvollziehbarkeit für Prüfer und hilft Entwicklern selbst, ihre Modelle zu debuggen und zu verbessern.

Die Gesetzgeber haben reagiert auf die rasante KI-Entwicklung. Allen voran hat die EU 2024 den AI Act verabschiedet – den weltweit ersten umfassenden Rechtsrahmen für KI. Dieser verfolgt einen risikobasierten Ansatz. KI-Anwendungen werden je nach Gefahrenpotenzial in Kategorien von minimalem bis unakzeptablem Risiko eingestuft. Unakzeptable KI (zum Beispiel Massenüberwachung oder Social Scoring wie in China) wird verboten. Hochriskante KI, zum Beispiel in Medizin, Personalwesen, Strafverfolgung, unterliegt strengen Auflagen, etwa hinsichtlich Datenqualität, Transparenz und menschlicher Aufsicht.

Konkret verlangt der AI Act unter anderem:

- Transparenzpflichten: Nutzer müssen informiert werden, wenn sie es mit einer KI zu tun haben (zum Beispiel Kennzeichnung von AI-generierten Inhalten). Generative Modelle wie ChatGPT müssen offenlegen, dass ihre Ausgaben maschinell erzeugt sind, und einen groben Überblick über die verwendeten Trainingsdaten geben.

- Überwachung durch Menschen: Hochrisiko-KI muss so konzipiert sein, dass menschliche Kontrolle möglich ist und bei Fehlfunktionen eingegriffen werden kann. Vollautomatisierte Entscheidungen ohne Möglichkeit menschlicher Intervention sollen in sensitiven Bereichen vermieden werden.

- Sicherheit und Genauigkeit: Anbieter solcher KI-Systeme müssen ein Risikomanagement betreiben, ihre Modelle auf Genauigkeit, Robustheit und Cybersicherheit prüfen und dokumentieren. Außerdem sind Behörden zu informieren, wenn schwerwiegende Vorfälle oder Fehler passieren.

Verstöße gegen den AI Act können empfindliche Strafen nach sich ziehen; bis zu 30 Millionen Euro oder 6 Prozent des weltweiten Jahresumsatzes. Für Entwickler bedeutet das: Regulatory Compliance wird Teil des KI-Projektlebenszyklus. Es ist ratsam, sich früh mit den Vorgaben vertraut zu machen, insbesondere wenn man KI-Lösungen in der EU bereitstellen will. Neben dem AI Act sind auch bestehende Gesetze relevant, zum Beispiel die DSGVO bezüglich personenbezogener Daten oder branchenspezifische Regularien.

Abschließend lassen sich einige bewährte Praktiken nennen, die im KI-Projektalltag helfen, Ethik und Verantwortung fest zu verankern. Ein zentraler Aspekt ist die Vermeidung von Daten-Vorurteilen. Bereits beim Sammeln der Daten sollte auf Vielfalt geachtet werden, um möglichst ausgewogene Datensätze zu erhalten. Automatisierte Bias-Checks – etwa das regelmäßige Prüfen von Fehlerraten für verschiedene Untergruppen – sind essenziell, um Verzerrungen frühzeitig zu erkennen. Werden Ungleichgewichte festgestellt, können Methoden wie Nachsampling oder Gewichtung eingesetzt werden, um diese zu korrigieren.

Ebenso wichtig ist die Förderung der Erklärbarkeit. Wo immer möglich, sollten interpretierbare Modelle bevorzugt werden, beispielsweise Entscheidungsbäume statt komplexer Black-Box-Modelle für einfache Aufgaben. Ist dies nicht praktikabel, bieten Explainable-AI-Methoden (XAI) wertvolle Einblicke. Sie zeigen nach jedem Modelltraining auf, welche Merkmale maßgeblich zur Entscheidung beigetragen haben. Diese Analysen sollten dokumentiert und in verständlicher Form für Stakeholder aufbereitet werden.

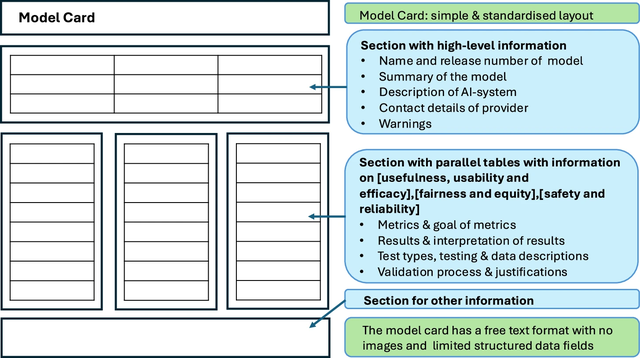

Darüber hinaus spielt Dokumentation und Transparenz eine Schlüsselrolle. Eine sogenannte Model Card, das Konzept dient dazu, für jedes Modell festzuhalten, welche Daten verwendet wurden, wofür es geeignet ist und wofür nicht, sowie wie es in unterschiedlichen Gruppen performt (Bild 9).

Beispiel einer Model Card zur Erklärung eines KI-Models (Bild 9)

Nature.comSolche Transparenzdokumente fördern nicht nur Vertrauen nach außen, sondern unterstützen auch den Wissensaustausch innerhalb von Teams. Zusätzlich sollten Entscheidungen von KI-Systemen geloggt und archiviert werden, um sie später nachvollziehen und evaluieren zu können.

Schließlich gewinnt das Thema AI Governance zunehmend an Bedeutung. Größere Organisationen etablieren Ethikräte oder AI-Beauftragte, die Leitlinien erarbeiten und deren Einhaltung überwachen. Entwickler sollten diese Richtlinien, etwa zu Fairness, Nicht-Diskriminierung und Datenverwendung, ernst nehmen und in ihren Arbeitsalltag integrieren. Eine enge Zusammenarbeit mit den Rechtsabteilungen hilft zudem, neue regulatorische Vorgaben wie den europäischen AI Act umfassend zu berücksichtigen.

Fassen wir zusammen: Ethik in der KI ist kein „nice to have“, sondern eine Voraussetzung für nachhaltigen Erfolg. Nur wenn KI-Systeme vertrauenswürdig und transparent sind, werden sie von Anwendern und der Gesellschaft akzeptiert. Für Entwicklerinnen und Entwickler entsteht dadurch ein neues, anspruchsvolles, aber auch lohnendes Aufgabenfeld – die Chance, KI so zu gestalten, dass sie im Einklang mit menschlichen Werten steht. Das Thema Responsible AI wird in Zukunft zweifellos weiter an Bedeutung gewinnen.

Zukünftige Bedeutung der Programmiersprache Python

Die Softwareentwicklung bleibt zentraler Motor für Innovation und Wirtschaft – und ihr Einfluss wächst weiter. Trends wie Künstliche Intelligenz, Automatisierung, Cloud-native Entwicklung oder Low-Code/No-Code verändern, wie Software entsteht. In diesem Wandel behauptet sich Python als eine der wichtigsten Sprachen: flexibel, leicht erlernbar, mit starkem Ökosystem. 2025 gilt Python laut Entwicklerumfragen als gefragteste Sprache weltweit – dank ihrer Vielseitigkeit von Webentwicklung bis KI.

Auch AutoML-Tools und KI-Frameworks basieren auf Python. Damit bleibt die Sprache das Rückgrat der KI-Entwicklung – und zunehmend selbst Bestandteil intelligenter Entwicklungsumgebungen, etwa in Form von Code-Assistenten. Durch seine klare Syntax und breite Bibliothekslandschaft eignet sich Python ideal für Skripting, Datenverarbeitung und Workflow-Automatisierung. KI-basierte Code-Reviews oder Testsysteme werden dabei zunehmend in Python entwickelt und genutzt.

Gleichzeitig ist Python tief in der Open-Source-Kultur verwurzelt. Tausende frei verfügbare Bibliotheken treiben Innovation voran, ob für Web, Data Science oder Automatisierung. Auch die Sprache selbst entwickelt sich offen weiter.

In der wachsenden Plattform-Ökonomie wird Integration zum Schlüssel. Unternehmen bauen auf Cloud- und API-Plattformen auf. Python dient dabei als „Klebstoff“. Durch unzählige SDKs und REST-Clients verbindet Python unterschiedliche Systeme und Dienste, automatisiert Geschäftsprozesse und analysiert Plattformdaten. So wird Python in Unternehmen zum universellen Werkzeug: leicht anzubinden, schnell zu deployen und bestens dokumentiert.

Python hat sich zur wichtigsten Lehr- und Einstiegssprache in Schulen, Universitäten und Online-Kursen entwickelt. Ihre Lesbarkeit und Vielseitigkeit senken Hürden für den Einstieg und fördern Nachwuchs. Zugleich nutzen erfahrene Entwickler:innen Python, um sich in neue Bereiche wie KI oder Cloud Computing einzuarbeiten. Die große Community, umfangreiche Dokumentation und Lernressourcen machen Python zu einem entscheidenden Faktor in einer sich ständig wandelnden IT-Welt.

Fazit und Ausblick

Python und KI bleiben untrennbar verbunden. Dieser Artikel hat gezeigt, wie Python zum Fundament moderner KI-Entwicklung wurde. Wir haben klassische ML-Methoden ebenso gestreift wie Deep Learning und aktuelle Trends. In kommenden Teilen der Artikelserie werden wir noch tiefer in Spezialthemen einsteigen, zum Beispiel detaillierte Praxis-Tutorials. Für erfahrene Entwickler bleibt die Herausforderung, in dieser dynamischen Landschaft auf dem Laufenden zu bleiben. Doch mit Python als verlässlichem Werkzeug in der Hand und einer wachsenden Fülle an Ressourcen war es vielleicht noch nie so spannend wie heute, im Feld der KI zu arbeiten. Die Reise geht weiter, von AutoML über immer mächtigere Foundation Models bis hin zu autonomen KI-Agenten. Stand heute: Python wird uns dabei als vertrauter Begleiter dienen.

Happy coding!

Glossar

| Begriff | Erklärung |

| Backpropagation | Algorithmus zur Optimierung neuronaler Netze. Er berechnet, wie stark jedes Gewicht im Netzwerk zum Fehler beiträgt, und passt diese Gewichte mithilfe von Gradientenabstieg an. Grundlage für das Training moderner Deep-Learning-Modelle. |

| Deep Learning | Teilbereich des Machine Learning, der auf tiefen (mehrschichtigen) neuronalen Netzen basiert. Wird für komplexe Aufgaben wie Bild-, Sprach- und Textverarbeitung verwendet. |

| Explainable AI (XAI) | Teilgebiet der KI-Forschung, das Methoden entwickelt, um die Entscheidungen von KI-Modellen nachvollziehbar zu machen. Ziel ist es, Vertrauen und Transparenz zu fördern, zum Beispiel durch Visualisierungen oder lokale Erklärungen. |

| Feature Importance-Techniken | Methoden, die den Einfluss einzelner Eingabevariablen (Features) auf die Vorhersage eines Modells messen. Dienen der Erklärbarkeit und Modellvalidierung. |

| Generative AI | KI-Modelle, die neue Inhalte (Text, Bilder, Audio, Code) erzeugen können. Beispiele sind GPT für Text oder Stable Diffusion für Bilder. Sie basieren meist auf neuronalen Netzen wie Transformern oder Diffusionsmodellen. |

| Machine Learning (ML) | Oberbegriff für Verfahren, bei denen Computer aus Daten Muster erlernen, anstatt explizit programmiert zu werden. Umfasst überwachte, unüberwachte und verstärkende Lernmethoden. |

| NLP-Modelle (Natural Language Processing) | Modelle zur Verarbeitung und Analyse natürlicher Sprache. Sie ermöglichen Aufgaben wie Textklassifikation, Übersetzung, Chatbots oder semantische Suche. Moderne Varianten basieren oft auf Transformer-Architekturen. |

| Perzeptron | Einfachster Typ eines künstlichen Neurons, das Eingaben gewichtet, summiert und durch eine Aktivierungsfunktion auswertet. Historisch das Grundmodell für neuronale Netze. |

| Responsible AI | Ansatz für verantwortungsvolle KI-Entwicklung, der ethische, rechtliche und gesellschaftliche Aspekte berücksichtigt. Ziel ist eine faire, transparente und sichere Nutzung von KI-Systemen. |

| Softmax-Aktivierung | Aktivierungsfunktion, die Rohwerte in Wahrscheinlichkeiten umwandelt. Wird meist in der Ausgabeschicht von Klassifikationsmodellen eingesetzt. |

| TPU-Hardware (Tensor Processing Unit) | Von Google entwickelte spezialisierte Hardware für KI-Berechnungen. TPUs sind optimiert für TensorFlow- und Matrixoperationen und beschleunigen Deep-Learning-Modelle erheblich. |

| Transformer-Netzwerke | Neuronale Netzarchitektur, die mit sogenannten Attention-Mechanismen arbeitet, um Beziehungen zwischen Eingabeelementen zu modellieren. Grundlage moderner LLMs wie GPT oder BERT. |

| Überwachtes Lernen (Supervised Learning) | Lernmethode, bei der Modelle anhand von Daten mit bekannten Zielwerten trainiert werden. Ziel ist es, eine Funktion zu lernen, die Eingaben korrekt auf Ausgaben abbildet. Wird zum Beispiel für Klassifikation und Regression genutzt. |