18. Mai 2020

Lesedauer 13 Min.

KI und Ethik

Der künstlichen Intelligenz ein Gewissen geben

Neben technischen Erfordernissen bringt das Umsetzen eines KI-Projekts für Entscheider und Entwickler auch eine konzeptionelle Herausforderung: das Thema Ethik und Moral.

Bereits seit Anbeginn der ersten Konzepte und Ideen für künstliche Intelligenz (KI; Artificial Intelligence, AI) oder menschenähnliche Robotik gibt es Diskussionen über das Für und Wider von teilautonom handelnden Maschinen und Algorithmen. Selten ist eine eigentlich rein technisch geprägte Konzeption so sehr und vor allem so kontrovers gesellschaftlich und philosophisch in die Diskussion gelangt.Angefangen haben die ersten Ideen zur künstlichen Intelligenz in den sechziger Jahren des vergangenen Jahrhunderts. Diese entstanden hauptsächlich in der Science-Fiction-Literatur und wurden bereits da sowohl teils als utopisch wie auch als dystopisch angesehen.In den vergangenen zwanzig Jahren erhielten immer mehr automatisierte Systeme zumindest einzelne Bausteine einer künstlichen Intelligenz, ob dies nun Klassifikationen sind, die uns in Onlineshops automatisch in Kundengruppen unterteilen und dank derer wir entsprechend optimierte Werbung erhalten, oder ob es sich um Regressions-Algorithmen handelt, die in der Industrie dafür sorgen, dass uns Maschinen vor einem Ausfall warnen können.Im Normalfall verbinden Entwickler oder technisch versierte Nutzer das Thema künstliche Intelligenz mit den positiven Effekten und dem möglichen Nutzen, den diese den Nutzern oder der Gesellschaft bringen können. Trotz aller Euphorie, den technisch immer besseren Werkzeugen oder auch der enormen Rechenleistung, welche uns derzeit zur Verfügung steht, gibt es in jeder Umsetzung Risiken, die in der Konzeption mit bedacht werden müssen.Einfach ausgedrückt müssen KI-Projekte oftmals mit entsprechender Ethik versehen werden, um negative Auswirkungen auf Entwickler, Unternehmen oder allen voran auf Personen auszuschließen.Ein meist nicht beachteter Teil ist das Treffen von Entscheidungen durch die KI-Modelle, die aus Sicht des Menschen als unethisch gelten. Deren Auswirkungen können entweder direkter Natur sein, wie zum Beispiel gravierende und vermeidbare Fehlentscheidungen, oder auch indirekter Art, wie zum Beispiel Diskriminierung. Diesen Punkten kann mittels ethischer Grundzüge zumindest entgegengewirkt werden.

Was ist Ethik?

Oft verwendet man den Begriff „Ethik“ im direkten Zusammenhang mit den moralischen Regeln und Wertvorstellungen einer Gesellschaft oder Kultur. Die „Moral“ als solche ist jedoch nur ein Teilbereich der Ethik, in der darüber hinaus noch viel mehr Aspekte in Betracht gezogen werden.Das Wort „Ethik“, das von dem griechischen Wort „ethos“ stammt, kann zum Beispiel mit „Sitte“ übersetzt werden. Die Grundsätze der Ethik wurden bereits im vierten Jahrhundert vor Christus definiert und gehen auf den Philosophen Aristoteles zurück, der die Ethik als eigene Disziplin in der Philosophie etabliert hat.Asimov’sche Gesetze

0. Ein Roboter darf die Menschheit nicht verletzen oder <br/>durch Passivität zulassen, dass die Menschheit zu Schaden kommt.

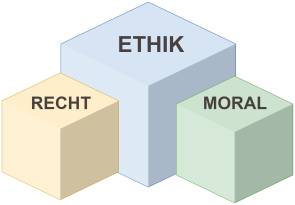

Seit diesem Zeitpunkt stellen sich immer wieder die Fragen danach, welche Aspekte die Ethik beinhalten muss. Im Zentrum der Ethik steht die Moral – also das allgemeine Werteverständnis. Dieses wurde von dem römischen Politiker und Anwalt Cicero geprägt. Diese Grundsätze finden sich auch heute noch in unseren Wertevorstellungen wieder. Sie sind teils definierte und festgeschriebene, teils auch ungeschriebene Regeln. Eine benachbarte Disziplin hierzu ist zum Beispiel die Rechtsphilosophie, die sich entsprechend auf moralische Grundwerte beruft.Aufgrund dessen kann man solche einzuhaltenden Regeln – ähnlich wie beim gesellschaftlichen Leben – entweder als niedergeschriebene und logisch vertretbare Regeln sehen oder als „ungeschriebene Gesetze“, welche sich meist durch Erziehung und Umfeld festigen.In der Ethik gibt es noch viele weitere Disziplinen, die zum Beispiel das logische Handeln betreffen. In diesem Artikel werde ich mich jedoch auf die beiden genannten Disziplinen Moral und Recht beziehen, da diese den umfassendsten Einfluss auf die Arbeit mit künstlicher Intelligenz haben (vergleiche Bild 1).

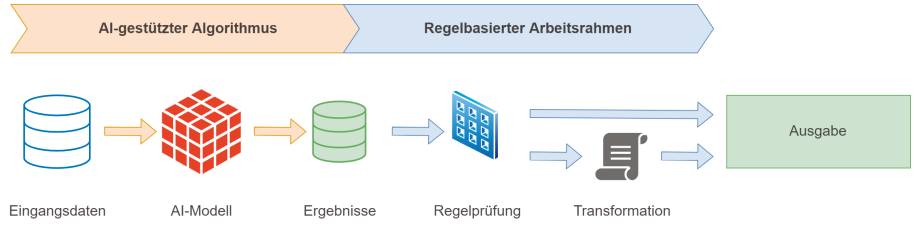

Moral und Rechtals Teil der Ethik(Bild 1)

Autor

Warum braucht KI überhaupt Ethik?

Diese ethischen Vorstellungen, welche Moral und Recht vereinen, kennt eine KI selbstverständlich nicht. Würde man zum Beispiel ein autonomes Fahrzeug allein darauf trainieren, möglichst effizient von A nach B zu kommen, ohne vorab die Regeln und gegebenenfalls Moralwerte festzulegen, wäre das für die anderen Verkehrsteilnehmer kurz gesagt tödlich. Auch Fußgängerwege, rote Ampeln oder Fahrradwege würden hier wie selbstverständlich dafür genutzt werden, möglichst effizient das eigene Ziel zu erreichen, komme, was wolle. Mit einigen Trainingsrunden würde der Algorithmus nur den eigenen Gefahren aus dem Weg gehen – sprich bei einem Pkw eventuell die Lkws und Gebäude meiden.Das Thema „autonomer Verkehr“ wird immer wieder groß diskutiert, vor allem dann, wenn ein Algorithmus eine falsche Entscheidung getroffen hat. Hier muss man jedoch bedenken, dass die derzeitig genutzten Algorithmen bereits sehr gut funktionieren und ohne das jahrelange Training und Erweiterungen sowie die klare Definition von Grenzen, Regeln und Plausibilitätsprüfungen heute viel mehr Unfälle verursachen würden und damit untauglich wären.Ein weiterer Aspekt sind nicht nur die autonomen Fahrzeuge oder Maschinen, die nach einem bestimmten Schema teilweise selbstständig arbeiten. Hier geht es auch um recht einfache Algorithmen und Anwendungsszenarien.Eine relativ weit bekannt gewordene, unfreiwillige Verselbstständigung einer KI geschah bei einem Forschungsprojekt von Microsoft. Im Jahr 2016 veröffentlichte Microsoft, die im Thema KI und entsprechende Frameworks auch uns Entwicklern entsprechende Werkzeuge an die Hand geben, einen Chatbot. Dieser Chatbot twitterte automatisiert und antwortete auf Tweets.Dieser Bot mit dem Namen Tay begann zuerst über relativ triviale Themen zu twittern. Nach einiger Zeit ging er jedoch dazu über, immer mehr anstößige, diskriminierende und rassistische Tweets zu verfassen. Nach wenigen Stunden wurden Tweets verfasst, welche ganz klar auch rechtliche Grenzen überschritten und für einen Menschen sicher auch mit einer Strafanzeige hätten enden können. Tay wurde nach kurzer Zeit aktualisiert, aber aufgrund erneut auftretender Tendenzen relativ schnell wieder offline genommen.Diese und auch andere Vorkommnisse erfordern es, den mit künstlicher Intelligenz ausgestatteten Systemen eine Ethikvorstellung und Regelsätze vorzugeben. Klar ist hierbei, dass die technische Umsetzung eines solchen Spielraums teils sehr individuell ausfällt, aber heute noch nicht eindeutig zu klären ist.Was ist mit Gesetzen?

Als Teil der Ethik spielt natürlich die Einhaltung von klar definierten Gesetzen eine Rolle. Welche Gesetze hierfür eingehalten werden müssen, unterscheidet sich selbstverständlich je nach Anwendungszweck. Ein teilautonom arbeitender Roboter hat andere Regeln einzuhalten als ein Algorithmus für automatisierte Aktien- und Depot-Transaktionen.Bereits in den vierziger Jahren des vergangenen Jahrhunderts definierte der Schriftsteller Isaac Asimov die „Grundregeln des Roboterdienstes“. Diese Regeln sind heute als Asimov’sche Gesetze oder Robotergesetze bekannt (vergleiche Kasten Asimov’sche Gesetze). Sie definieren im Grunde die Zusammenarbeit von Menschen und Robotern. In einer erweiterten Form kann man diese Regeln jedoch klar auf alle Automatismen und künstlichen Intelligenzen anwenden. Egal ob physische Maschinen oder Algorithmen, welche keine physischen Aktionen ausführen.Natürlich treten diese Gesetze auch immer wieder einmal in Konflikt zueinander auf. Ein Algorithmus, der automatisierte Bestellungen zu dem für den Nutzer günstigsten Preis auslöst, kann interpretationsweise einen Schaden für den Verkäufer bedeuten. Also muss hier die Frage gestellt werden, ob sich KIs denn grundsätzlich in Einklang mit den Asimov’schen Gesetzen bringen lassen.Gesetze, die rechtlich und juristisch definiert sind, haben hier jedoch weitaus weniger Interpretationsspielraum. Nehmen wir das Beispiel eines Chatbots, der als Support-Mitarbeiter funktionieren soll und einem Kunden bei Anfragen weiterhilft. Wird dieser Chatbot durch die Unterhaltungen, die er geführt hat, immer weiter trainiert, hat dies erst einmal die Auswirkung, dass sein Anteil an der Kommunikation natürlicher wirkt. Ein relativ guter Aspekt also. Was aber, wenn die Kunden sich häufig beschweren oder deren Wortwahl etwas rauer wird? Möchte man, dass ein Bot hier mitzieht und einen eigenen Kunden grob angeht oder gar beleidigt?Das grobe Angehen eines Kunden mag zwar rechtlich noch zu verkraften sein, jedoch nicht wirtschaftlich. Spätestens bei einer Beleidigung und einer möglichen Klage stellt sich dann die Frage, wer verantwortlich ist. Zu dem Thema Konsequenzen werde ich später im Artikel noch einmal zurückkommen. An dieser Stelle sieht man jedoch sehr eindrucksvoll, wie wichtig es sein kann, zumindest die äußersten Grundsätze und Gesetze in der Implementierung zu befolgen, um keinen Schaden heraufzubeschwören – ganz unabhängig davon, welchen Nutzen man sich von der KI verspricht und wie „harmlos“ sie zu erscheinen vermag.Zusätzlich hierzu gibt es noch die Aspekte, die nicht klar zu entscheiden sind und selbst von Menschen oft sehr unterschiedlich interpretiert werden. Gerne werden sogenannte Dilemma-Situationen herangezogen, bei denen unabhängig davon, wie die Entscheidung getroffen wird, ein Schaden nicht mehr abgewendet werden kann und die Entscheidung getroffen werden muss, wem oder was geschadet werden soll. Ein typisches Beispiel ist das sogenannte Trolley-Problem, das in abgewandelten Formen auch häufig für das autonome Fahren herangezogen wird. In diesem Anwendungsgebiet wird oft die Frage gestellt, ob man eine Person opfern darf, um mehrere andere zu retten.Ein Beispiel: Ihr autonomes Fahrzeug fährt auf einer Straße und es biegt ein anderes Fahrzeug direkt auf dessen Fahrbahn ein. Ihr Fahrzeug würde demnach ausweichen, jedoch befindet sich auf der Gegenfahrbahn gerade eine weitere Person. Soll also Ihr Fahrzeug einen Unfall provozieren und Sie sowie die Fahrer und Beifahrer des gegnerischen Fahrzeuges in Gefahr bringen? Oder soll Ihr Fahrzeug das Ausweichmanöver durchführen und die Person auf der Fahrbahn mit hoher Sicherheit schwer verletzen oder gar töten?In dieser Betrachtungsweise ist klar, dass ein Algorithmus – egal wie trainiert oder spezifiziert – niemals den Asimov’schen Gesetzen entsprechen kann. Jedoch können solche ethischen Dilemmas jeden, also insbesondere auch einen menschlichen Fahrer treffen, und, egal wie die Entscheidung ausfällt, einen nicht unerheblichen Schaden hervorrufen.Dieses Verhalten kann man sehr häufig in einem weniger drastischen Beispiel sehen. Mittlerweile nutzen Kredit- und Versicherungsinstitute künstliche Intelligenz oder statistische Auswertungen, um eine Risikoeinschätzung ihrer Kunden zu erstellen. Hierbei kommt es häufig vor, dass Personen unterschiedlichster Herkunft, Gehaltsstufen oder Berufe vom Algorithmus als hohes Risiko beziehungsweise mit niedriger Bonität eingestuft werden. Da stellt sich die Frage, wo die Objektivität in einem solchen Algorithmus endet und wo die Diskriminierung beginnt. Im bereits erwähnten Beispiel des Chatbots Tay ist dies klar – ja, auch ein Algorithmus kann diskriminierend sein, wenn er entsprechend trainiert wird.Anders als ein Mensch trifft jedoch jede Maschine und jeder Algorithmus – auch mit KI – immer Entscheidungen, die auf einer mathematischen Grundlage basieren. So etwas wie Instinkt, Empathie oder Unterbewusstsein gibt es auch in der Welt der künstlichen Intelligenz nicht. Dadurch sind Entwickler und Ingenieure dieser Systeme schlicht verpflichtet, sich mit diesen Aspekten auseinanderzusetzen.Wie kann man KI eine Ethik verleihen?

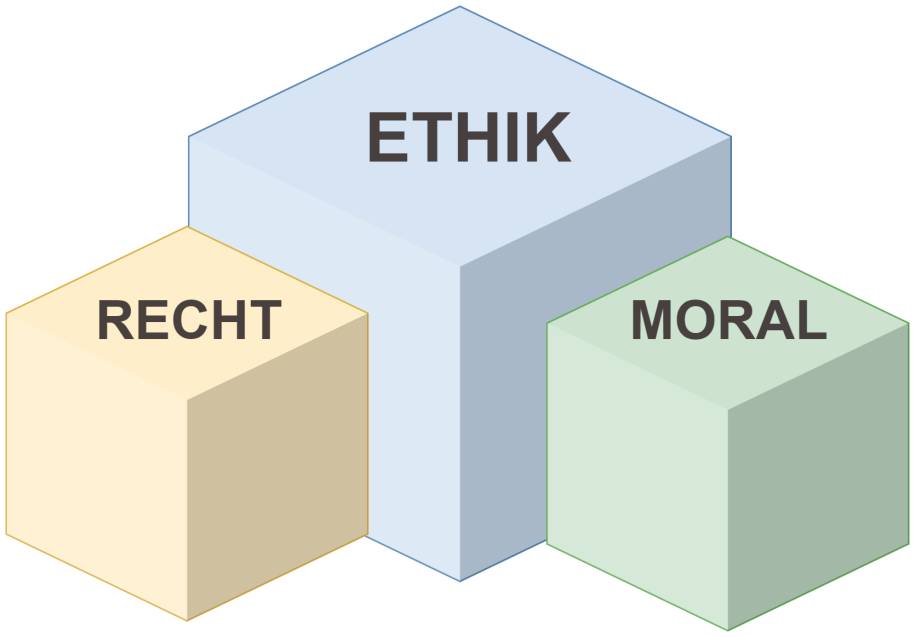

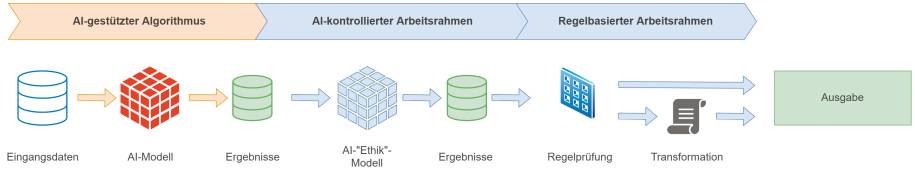

Man kann gut erkennen, dass es im Fall der Ethik sowohl klar abgrenzbare Regeln gibt wie auch Aspekte, die „schwimmend“ sein können.Ein Ansatz ist der regelbasierte Arbeitsrahmen (vergleiche Bild 2). Dieser eignet sich besonders für das Einhalten gesetzlicher und eindeutig definierbarer Regeln. Hierbei wird nach dem Entscheidungsprozess einer KI sowohl anhand der Eingangs- beziehungsweise Rohdaten und dem daraus herausgegangenen Ergebnis entschieden, ob das Gesamtergebnis den gewünschten und implementierten Regeln entspricht. Der regelbasierte Algorithmus spielt so gesehen die „Anstandsdame“ für den KI-gestützten Algorithmus.

Architekturdes regelbasierten Arbeitsrahmens(Bild 2)

Autor

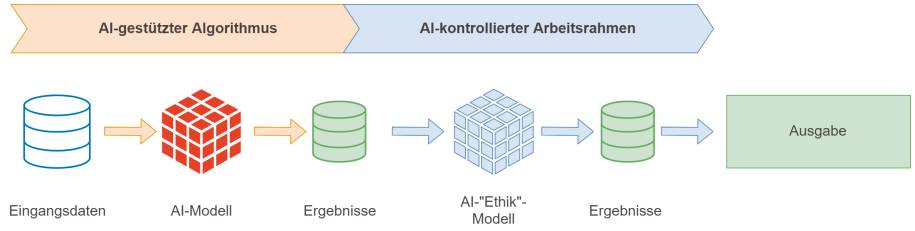

Dieser Ansatz kann zumindest die minimal einzuhaltende Ethik festlegen und grobe Verstöße verhindern. Wird ein Verstoß erkannt, so kann entweder der Datensatz beziehungsweise das Ergebnis im Hinblick auf seine Konfidenz nach unten gesetzt werden, sodass die nachfolgenden Prozesse wissen, dass dieser nicht valide sein kann, oder es lassen sich alternativ die Ergebnisdaten so transformieren, dass sie den Mindestanforderungen genügen. Je nach Anwendungsfall kann diese Struktur entweder „hart“ im Anwendungscode dem Workflow angehängt oder nach Belieben generisch umgesetzt werden.Ein weiterer Ansatz ist die Umsetzung als KI-gestützte Ethik (vergleiche Bild 3). Nun werden sich viele fragen, wie so etwas funktionieren kann, wenn man doch der eigenen KI nicht vertrauen kann beziehungsweise soll. Dieser Ansatz richtet sich hauptsächlich auf die sogenannten „schwimmenden“ Regeln und teils moralischen Vorstellungen. Man trainiert demnach ein weiteres KI-Modell mit vorhandenen Eingangsdaten und einer Variation an Ergebnissen. Hierbei nimmt man die Ergebnisse mit in den Trainingssatz auf und klassifiziert die Ergebnisse zu den Rohdaten zwischen „konform“ und „nicht konform“, beziehungsweise „ethisch“ oder „unethisch“. Dies hat den Vorteil, dass auch hier durch Revisionen die Moralvorstellungen des KI-Modells immer neu gebildet und optimiert werden.

Architekturdes KI-gestützten Arbeitsrahmens(Bild 3)

Autor

Somit existiert ein KI-Modell, welches ein anderes KI-Modell überprüft und bereits vor der Ausgabe definieren kann, ob die Ergebnisse den Wertvorstellungen entsprechen oder nicht. Dies erspart relativ aufwendig umzusetzende Regeln und bietet zugleich ein flexibleres und menschenähnlicheres Verhalten. Ich werde nachfolgend darauf eingehen, wie wichtig ein solches Verhalten im Hinblick auf die Akzeptanz des Nutzers sein kann.Selbstverständlich ist weder die eine noch die andere Variante eine absolute Lösung für dieses komplexe Themengebiet. Jedoch kann damit ein Anfang gemacht werden und ein zunächst relativ unvorhersehbar agierender Algorithmus in gewisser Weise gesteuert werden.Oft empfiehlt sich hier ein kombiniertes Konstrukt aus den beiden Ansätzen (vergleiche Bild 4), da es nur in wenigen Anwendungsfällen entweder eine reine flexible Variante oder eine reine starre Variante geben kann.

KombinierteArbeitsrahmen(Bild 4)

Autor

Mit der kombinierten Variante erschafft man sich zwar eine doppelte Sicherheit, kann aber auch schnell Gegensätze umsetzen. Ein Beispiel hierfür wäre die Kreditprüfung. Das KI-Modell entscheidet, dass einer Person aufgrund ihres Berufs und Wohnortes kein erhöhter Kreditrahmen gewährt werden kann. Das Ethik-KI-Modell entscheidet jedoch, dass dies diskriminierend sein könnte, und setzt die Konfidenz dieser Entscheidung nach unten. Die regelbasierte KI wiederum kommt zu dem Schluss, dass alle regelbasierten Gründe eingehalten sind und die Person trotz Beruf und Wohnort ein relativ hohes Einkommen und Sicherheiten hat, was diesen Kreditrahmen (rein rechnerisch) rechtfertigen würde. Was ist also nun zu entscheiden und wie zu gewichten? In einem solchen Fall kann entschieden werden, dass ein Mitarbeiter der Bank diesen Fall individuell prüfen muss, was jedoch den Ablauf wieder verlängert und den Nutzen der KI schmälert.Es muss also differenziert betrachtet werden, welche Wechselwirkungen auftreten können und wie die Gewichtungen gesetzt werden müssen. Tritt etwa die Situation ein, dass jede zweite Anfrage durch die KI nicht entschieden werden kann, ergibt deren Einsatz wenig Sinn und die Akzeptanz beim Kunden ist nicht gegeben. Entsprechend ist das Gegenteil ebenfalls wenig förderlich, wenn also eine hohe Produktivität durch die KI gegeben ist, sich jedoch nach einiger Zeit herausstellt, dass viele Fälle mit Beschwerden oder manuellen Nacharbeiten endeten.