Generative AI und Python

Python und AI, Teil 4

In diesem Teil der Serie zu Python und AI dreht sich alles um generative KI – also Systeme, die Texte, Bilder oder Code eigenständig erzeugen. Wir werfen einen Blick auf die zugrunde liegenden Modellarten und zeigen, wie Entwickler GPT-4 und GPT-5 über das OpenAI-API effektiv in Python-Projekte integrieren können – inklusive Beispielcode, Anwendungsszenarien und MLOps-Praxis.Generative KI bezeichnet KI-Modelle, die neue Inhalte erzeugen können, das heißt Texte, Bilder, Audio oder Quellcode, anstatt nur vorhandene Daten zu analysieren.

Dahinter stehen spezialisierte Modellarchitekturen. Generative Adversarial Networks (GANs) nutzen zwei Netze – Generator und Diskriminator – die verwendet werden, um realistisch wirkende Daten (zum Beispiel Bilder) zu erzeugen. Diffusionsmodelle wandeln hingegen schrittweise zufälliges Rauschen in aussagekräftige Daten um und erzielen so insbesondere in der Bildgenerierung (zum Beispiel Stable Diffusion) beeindruckende Resultate.

Einen dritten entscheidenden Durchbruch brachten Transformer-Netzwerke. Diese 2017 vorgestellte Architektur nutzt Aufmerksamkeitsmechanismen („Attention“), um Zusammenhänge in Sequenzen effizient zu modellieren. Transformer bilden die Grundlage der heutigen Large Language Models (LLMs) wie GPT. GPT-3, GPT-4 und das neue GPT-5 sind Transformer-Modelle, die mit sehr großen Textmengen vortrainiert wurden und dadurch erstaunlich kohärente, kontextbezogene Texte generieren können. Generative KI hat spätestens seit 2022 enorm an Bekanntheit gewonnen – nicht zuletzt dank frei zugänglicher Systeme wie ChatGPT. Entwickler stehen nun vor der Aufgabe, diese leistungsfähigen Modelle effektiv in ihre Python-Projekte zu integrieren.

Use Cases

Generative KI-Modelle bieten enormes Potenzial, eigene Anwendungen intelligenter, adaptiver und nutzerzentrierter zu gestalten. Sie können Inhalte nicht nur analysieren, sondern selbstständig erzeugen – sei es Text, Code, Bilder oder Dialoge. Damit lassen sich viele Aufgaben automatisieren oder deutlich vereinfachen. Ein typisches Beispiel ist der Einsatz in Support-Chatbots, die auf Basis von GPT-4 kontextbezogen antworten, Anfragen zusammenfassen und auch bei komplexeren Fragen helfen – weit über vordefinierte Antworten hinaus. In Textverarbeitungstools ermöglichen generative Modelle automatische Zusammenfassungen, Gliederungen oder das Umschreiben von Texten im gewünschten Stil. Auch in der Softwareentwicklung bieten sie echte Unterstützung: etwa beim Erklären von Code, dem Schreiben von Unit-Tests oder dem Generieren von Dokumentation. Dadurch können Entwickler effizienter arbeiten und repetitive Aufgaben gezielt delegieren.

Python ist die ideale Sprache für den Einsatz generativer KI-Modelle – aus mehreren Gründen. Erstens bieten nahezu alle großen KI-Frameworks und APIs (zum Beispiel OpenAI) native Python-Schnittstellen, die eine schnelle und einfache Integration ermöglichen. Zweitens ist das Ökosystem in Python besonders reichhaltig: von Bibliotheken für Datenverarbeitung (Pandas, NumPy) über Visualisierung (Matplotlib, Plotly) bis hin zu Tools für MLOps, Deployment oder Testing. Drittens unterstützt Python sowohl schnelles Prototyping in Jupyter-Notebooks als auch skalierbare Produktivsysteme. Für Entwickler bedeutet das: Man kann ein generatives Modell mit wenigen Zeilen testen, es in eine Anwendung einbauen – und es später in komplexe Workflows oder APIs integrieren. Python ist damit nicht nur Werkzeug, sondern das Rückgrat moderner KI-Entwicklung.

Textgenerierung mit GPT-4 und GPT-5 über das OpenAI-API

Die aktuell fortschrittlichsten Sprachmodelle sind GPT-4 und GPT-5 von OpenAI. GPT-4 erschien 2023 als großer Schritt gegenüber GPT-3.5. Es ist multimodal (akzeptiert neben Text zum Beispiel auch Bilder als Eingabe) und bewältigt deutlich größere Kontextmengen. GPT-5 wurde 2025 vorgestellt und kombiniert umfangreiche Reasoning-Fähigkeiten mit hoher Geschwindigkeit in einem einzigen Modell. Es setzt neue Maßstäbe auf vielen Benchmarks und wurde darauf trainiert, weniger Fehlinformationen zu halluzinieren und Anweisungen noch zuverlässiger zu befolgen. Für Entwickler ist der folgende Umstand besonders interessant: GPT-5 gilt auch als OpenAIs bisher stärkstes Modell für Quellcode-Generierung und kann aus einer einzigen Textbeschreibung teils komplette Anwendungen erstellen

.

Um GPT-4 oder GPT-5 in Python zu nutzen, stellt OpenAI ein komfortables API bereit. Anstatt ein riesiges Modell lokal zu betreiben, schickt man Anfragen an einen Cloud-Service. In diesem Fall übernimmt OpenAI das Hosting und eine mögliche Skalierung. Nach Installation des offiziellen Python-Pakets (pip install openai) kann das Modell mit wenigen Zeilen Code abgefragt werden. Wichtige Aspekte sind dabei API-Schlüssel (zur Authentifizierung), Kosten (Abrechnung meist pro Token) und Rate-Limits. Für Prototypen bis hin zu produktiven Anwendungen bietet das OpenAI-API einen schnellen Weg, um modernste Textgenerierung in eigene Projekte einzubinden.

Bildgenerierung mit OpenAI über das API

Generative Modelle können nicht nur Text, sondern auch Bilder erschaffen. Über das OpenAI-API lässt sich diese Funktion ähnlich nutzen wie die Texterstellung. Man übergibt einen Prompt (Bildbeschreibung) und erhält ein generiertes Bild. Ein API-Aufruf in Python könnte zum Beispiel so aussehen:

from openai import OpenAI

import base64

client = OpenAI()

prompt = """

A children's book drawing of a veterinarian using a stethoscope to

listen to the heartbeat of a baby otter.

"""

result = client.images.generate(

model="gpt-image-1",

prompt=prompt

)

image_base64 = result.data[0].b64_json

image_bytes = base64.b64decode(image_base64)

# Save the image to a file

with open("otter.png", "wb") as f:

f.write(image_bytes)

Auch andere Dienste bieten Bildgenerierung via API an. All diesen Angeboten ist gemein, dass Entwickler keine eigene GPU-Hardware benötigen – sie nutzen einfach das Cloud-API und können so direkt aus Python Grafiken erzeugen (für Web-Apps, Content-Erstellung, Design-Prototypen et cetera). Bei der Integration gilt es, die Inhaltsrichtlinien der Plattform zu beachten (zum Beispiel Filter gegen unzulässige Inhalte) und etwaige Fehler abzufangen. Insgesamt ermöglicht die API-basierte Bildgenerierung, visuelle Inhalte auf Knopfdruck zu erstellen, von Icons und Diagrammen bis hin zu einzigartigen „Kunstwerken“.

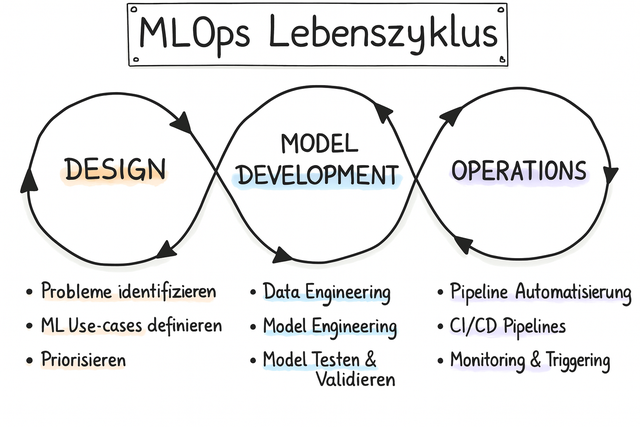

MLOps in generativen KI-Projekten

Sobald generative KI-Modelle produktiv eingesetzt werden, gewinnt das Thema MLOps, also der Einsatz bewährter DevOps-Praktiken für ML-Workflows, stark an Bedeutung. Große Modelle wie GPT werden zwar vom Anbieter gehostet, doch auch hier müssen Entwickler für Nachvollziehbarkeit, Qualitätssicherung und Betriebssicherheit sorgen. Ohne solide MLOps-Pipelines bleibt generative KI meist nur eine Demo und kein verlässliches System.

Modelle und Versionen sollten genau nachverfolgt werden. Bei externen APIs bedeutet das, festzuhalten, welche Modellversion (GPT-4, GPT-5 oder ein bestimmter Stand) die Anwendung nutzt. Wenn der Anbieter ein Update ausrollt, muss dieses gründlich getestet werden. Ebenso wichtig ist das Versionieren von Prompts: Prompt-Vorlagen sollten wie Code versioniert werden (mit Historie und Rollback-Möglichkeit). Tools wie MLflow helfen dabei. Sie bieten Experiment-Logging, Modellregistrierung und können sogar Prompts als Konfiguration festhalten. In diesem Zusammenhang gilt: Einen Prototyp zu bauen ist (meist) leicht, eine produktionsreife Anwendung zu erstellen dagegen ungleich aufwendiger und schwerer.

Es braucht auch Continuous Integration/Continuous Deployment (CI/CD) für KI-Funktionen. Bevor man ein aktualisiertes Modell oder einen Prompt live nimmt, sollten Tests sicherstellen, dass die Änderungen die Ergebnisse nicht verschlechtern. Klassische Metriken wie Accuracy reichen bei LLM-Ausgaben oft nicht aus. Stattdessen setzt man auf gezielte Evaluationen und bezieht Nutzerfeedback ein. Änderungen rollt man am besten schrittweise aus und überwacht die Outputs (ähnlich A/B-Tests), um unerwünschte Effekte früh zu erkennen.

Zum Betrieb generativer KI gehört Monitoring. Man sollte sowohl technische Metriken (Latenz, Fehlerraten) als auch inhaltliche Aspekte (zum Beispiel den Anteil problematischer Antworten) im Blick behalten. MLOps-Tools erleichtern das Sammeln solcher Daten. Bei generativen Systemen spielen neben dem Modell auch Prompts, Nutzungsdaten und Feedback eine große Rolle. Die DevOps-Grundprinzipien bleiben gleich: Automatisierung, Versionskontrolle, Überwachung und kontinuierliche Verbesserung sind entscheidend, um generative KI erfolgreich zu betreiben. Zudem braucht es klare Governance: Risiken wie Bias, Halluzinationen oder Prompt Injection müssen erkannt und durch Richtlinien, Filter und gegebenenfalls menschliche Kontrolle adressiert werden.

Praxisbeispiel: Textgenerierung mit dem OpenAI-API

Wir betrachten ein einfaches Beispiel in Python, das zeigt, wie man GPT-4 über das OpenAI-API ansprechen kann. Es ist ideal zum Ausprobieren in einem Jupyter-Notebook (Hinweis: Haiku ist eine traditionelle japanische Gedichtform):

import openai

openai.api_key = "<API-Schlüssel>"

frage = "Schreibe ein kurzes Haiku über Python und KI."

antwort = openai.ChatCompletion.create(

model="gpt-4",

messages=[{"role": "user", "content": frage}],

max_tokens=50,

temperature=0.7

)

print(antwort.choices[0].message["content"])

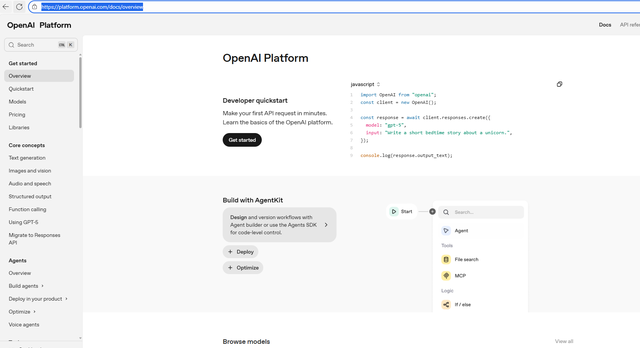

In diesem Beispiel wird ein Prompt an GPT-4 geschickt und die Antwort ausgegeben. Über Parameter wie max_tokens (maximale Antwortlänge) und temperature (Kreativität) kann das Verhalten der Generierung gesteuert werden. Mit wenigen Zeilen Code lässt sich so experimentieren – etwa unterschiedliche Prompts testen oder das Modell in eigene Anwendungen einbinden. Für einen produktiven Einsatz würde man zusätzlich Fehler abfangen und die Ausgaben nachbearbeiten. Im Developer-Portal von OpenAI kann man nach der Registrierung den notwendigen API-Key erhalten und auch die Dokumentation zu den einzelnen Befehlen einsehen (Bild 2).

Developer-Portal von OpenAI (Bild 2)

AutorFazit

In diesem Teil der Serie zu Python und AI wurde deutlich, wie generative Modelle wie GPT-4 und GPT-5 neue Möglichkeiten für Python-Projekte eröffneten. Entwickler können damit Texte, Dialoge oder Quellcode auf intelligente Weise generieren und eigene Anwendungen um neue kreative Fähigkeiten erweitern. Python erweist sich dabei erneut als ideale Schnittstelle zwischen Modell, Anwendung und Nutzer.

Insgesamt haben wir gesehen, wie Python sich über alle Stufen der KI-Entwicklung hinweg bewährt. Das gilt von klassischen ML-Verfahren über Deep Learning bis hin zur generativen KI. Aus heutiger Sicht können wir damit sagen, dass Python eine Schlüsseltechnologie für die KI-Anwendungen darstellt.